Uday (TechCrunch): «quando un cliente ha un problema, è verosimile che eviti le opzioni di risposta automatica per parlare con un operatore fisico in grado di risolvere il problema».

L’automazione svolge un ruolo centrale da oltre mezzo secolo, ma solo di recente ha iniziato a manifestare la sua vera natura di “distruzione creativa” à la Schumpeter. Non a caso, l’attuale fase di automazione inizia ad esercitare spinte distruttive sulle tradizionali forme di organizzazione della produzione in molti comparti.

L’attuale processo di diffusione dell’automazione è scarsamente assimilabile a tutto ciò che lo ha preceduto, essendo caratterizzato essenzialmente dal crescente ricorso all’intelligenza artificiale. E se si accetta l’interpretazione “tecnologica” di Bright, il controllo automatico dei processi produttivi che ne deriva condurrà ineluttabilmente alla sostituzione di funzioni attualmente svolte dall’uomo.

Tali mutamenti strutturali non saranno immediati, ma si esplicheranno nei prossimi 5-10 anni, non soltanto per la scarsità di figure professionali richieste dall’attuale fase di transizione, ma anche e soprattutto per i limiti che attualmente caratterizzano le applicazioni di IA, prima fra tutte la possibilità di interagire realmente in linguaggio naturale con l’essere umano. Infatti, già lo scorso anno, parlando di AlphaGo e dei progressi dell’IA, Will Knight notava sulla MIT Technology Review che «nonostante questi impressionanti avanzamenti, rimane esclusa una fondamentale capacità: il linguaggio».

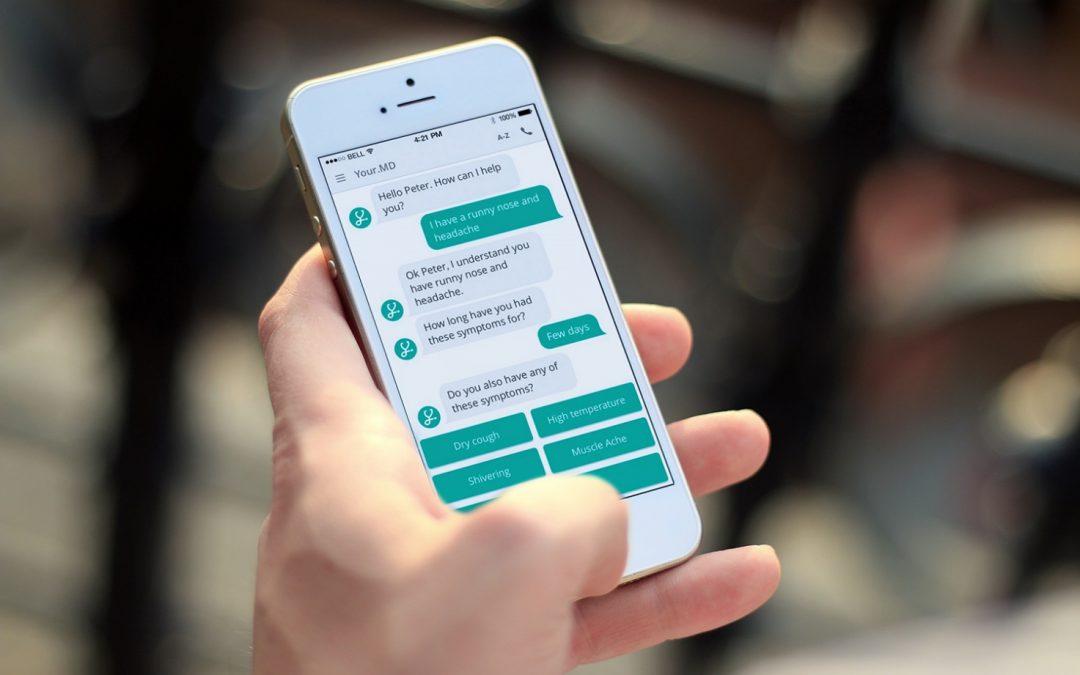

Questa limitazione è evidente soprattutto nel caso delle chatbot, la cui diffusione, come è sottolineato in un articolo di Andrea Daniele Signorelli recentemente pubblicato su Wired, sembra essersi arrestata, mentre il 78% degli statunitensi, evidenzia una ricerca svolta da Marketing Land, ancora ignora la loro esistenza.

Per quale motivo? In primo luogo le funzionalità promesse dalle chatbot – risposte personalizzate e un livello di assistenza confrontabile con quello assicurato da un assistente umano − sono spiazzate dall’esistenza di siti web ottimizzati per il mobile che consentono di interagire con rapidità per la maggior parte delle richieste dell’utilizzatore.

Inoltre, sottolinea Aron Uday su TechCrunch, «se il livello di conversazione di un bot è elevato, gli umani iniziano subito a esprimersi in maniera troppo colloquiale. A quel punto, il bot fallisce nel suo compito, creando frustrazione». Per questo motivo è implausibile che le chatbot si diffondano ulteriormente nell’assistenza clienti: infatti Uday osserva che «quando un cliente ha un problema, è verosimile che eviti le opzioni di risposta automatica per parlare con un operatore fisico in grado di risolvere il problema».

Fonte: Wired

Il flop dei chatbot

Nella Silicon Valley c’è la sensazione che la fantasia di creare un vero assistente personale stia per fare il suo grande ritorno.

Così si leggeva su The Verge all’inizio del 2016. Da allora, è passato circa un anno e mezzo, e a quanto pare quella “vecchia fantasia” è destinata a rimanere tale ancora per un bel po’. Ovviamente, l’utilizzo di Alexa di Amazon, Siri di Apple o Google Home (con i loro limiti) è in continua crescita; ciò che invece sembra essersi arrestato è la diffusione dei chatbot: gli assistenti virtuali con i quali comunicare in forma scritta che, a fronte anche della incredibile crescita dei servizi di instant messaging, sembravano dover essere la next big thing.

Una recente analisi di Marketing Land ha dimostrato come l’entusiasmo nei confronti dei chatbot si sia raffreddato e come, soprattutto, il 78% degli statunitensi non sappia nemmeno che cosa siano. Una statistica che pone serissimi dubbi su quanto siano effettivamente utilizzati gli oltre 30mila bot comparsi come funghi su Messenger dall’aprile 2016 a oggi, quando Mark Zuckerberg ha annunciato l’apertura a tutti gli sviluppatori della sua piattaforma di instant messaging.

La difficoltà dei chatbot è dimostrata anche dalla retromarcia compiuta da alcuni grossi marchi che avevano puntato su questo strumento: il negozio online Everlane ha da qualche mese annunciato di aver radicalmente limitato le funzionalità del suo bot, uno dei primissimi comparsi su Messenger, preferendo concentrarsi sulle email come strumento di marketing.

Stando a quanto riporta Digiday, anche un altro pioniere dei bot su Messenger, la startup dello shopping Spring, ha ammesso quanto i suoi clienti trovino il chatbot difficile da usare e dotato di uno scarso livello di personalizzazione.

Ma quali sono le ragioni delle difficoltà di uno strumento che sembrava destinato a conquistare internet? Prima di tutto, i bot devono vedersela con un rivale agguerrito: i siti web, ottimizzati per mobile e in cui basta scorrere i menu per trovare rapidamente quello che si va cercando, senza il rischio (sempre presente quando si usa un chatbot) di sprecare minuti e minuti nel tentativo di far capire all’interlocutore virtuale le nostre richieste. In più, tutto il parlare che si è fatto dei bot ha probabilmente illuso i primi utilizzatori di trovarsi davanti a strumenti in grado di dare risposte personalizzate e un livello di assistenza quasi alla pari di quello garantito da un assistente umano. Un altro aspetto importante viene invece sottolineato su TechCrunch:

Se il livello di conversazione di un bot è elevato, gli umani iniziano subito a esprimersi in maniera troppo colloquiale. A quel punto, il bot fallisce nel suo compito, creando frustrazione.

La delusione, insomma, è sempre dietro l’angolo.

C’è un solo bot che, a quanto pare, sta soddisfacendo ampiamente le attese dei suoi utilizzatori: M, l’assistente virtuale (e testuale) di Facebook che vive all’interno di Messenger. Il problema è che, da ormai quasi due anni, solo le 10mila fortunate persone, principalmente residenti in California e scelte come campione per la sperimentazione, possono godere dei suoi servizi. Volete prenotare un albergo in una località esotica, acquistare i biglietti del cinema o contattare una compagnia aerea per avere informazioni? Nessun problema, basta chiederlo a M, che provvederà a fare tutto ciò per conto vostro, riuscendo a comprendere anche le richieste più complesse.

Ma se funziona così bene, perché M non è ancora uscito dalla fase sperimentale per essere utilizzato dal miliardo e passa di utenti di Messenger? La ragione va ricercata nel “trucco” che permette all’assistente virtuale di Facebook di fare bene il suo dovere: ogni volta che il bot non è in grado di rispondere adeguatamente alle richieste dei suoi utenti, un operatore umano interviene e ne prende il posto, senza che nessuno se ne accorga. Una soluzione che può funzionare solo finché a utilizzare questo servizio sono poche migliaia di persone, ma che ovviamente impedisce di renderlo disponibile a tutti.

Il bot, originariamente, avrebbe dovuto sfruttare il lavoro degli operatori umani per imparare a svolgere meglio il suo lavoro, mentre l’interazione con gli utenti avrebbe dovuto fornire i dati necessari a espanderne le conoscenze.

Sapevamo che sarebbe stata un’enorme sfida, ma è ancora più complessa di quanto avessimo pensato

L’ha spiegato alla MIT Tech Review Alex Lebrun, che ha seguito il progetto fin dall’inizio. “Il tasso di apprendimento e la crescita dell’automazione sono più lenti di quanto sperassimo”.

Mentre Siri o Alexa vengono utilizzate quasi solo per le funzioni che sappiamo essere in grado di svolgere adeguatamente, gli utenti che stanno sperimentando un assistente a 360° come M hanno un approccio completamente diverso: “Le persone prima chiedono che tempo farà domani, poi vogliono sapere se c’è un ristorante italiano disponibile nei dintorni”, prosegue Lebrun. “Poco dopo cominciano a fare domande sulla politica estera e infine chiedono a M di organizzare il loro matrimonio”. Al di là del fatto che si tratta di operazioni complicate anche per un operatore umano, il vero problema è che più è ampia la diversificazione delle richieste, minori sono i dati su cui l’algoritmo del bot può fare affidamento.

Nonostante il sistema di deep learning alla base dell’intelligenza artificiale di M sia parecchio evoluto — ed è in grado, come la AI di Google DeepMind, di compiere un ragionamento embrionale grazie al riutilizzo di informazioni precedente immagazzinate — necessita comunque di un’immensa quantità di dati per portare a termine le sue operazioni. Le difficoltà di M sono state evidenziate da uno studio compiuto dagli esperti di The Information, secondo i quali il bot di Facebook è in grado di soddisfare solo il 30% delle richieste degli utenti se non intervengono gli operatori umani. Il tasso di fallimento, quindi, arriva al 70%: una percentuale decisamente troppo elevata.

Non stupisce, allora, che Facebook abbia deciso di fare marcia indietro sui progetti iniziali e di rendere invece disponibile agli utenti (per il momento solo negli Stati Uniti) la versione ridotta “M Suggestions”. Il funzionamento, da un certo punto di vista, è inverso: M non aspetta più di ricevere le domande, ma legge le vostre conversazioni per provare a rendersi utile quando pensa che sia il momento più opportuno; suggerendo la creazione di un evento sul Calendario, la prenotazione di una corsa su Uber o di lanciare un sondaggio in una chat tra amici.

Tutto questo, fa capire come un futuro in cui avremo davvero un assistente virtuale pronto a soddisfare ogni nostra esigenza sia ancora distante. Ma quanto distante? “Di solito diciamo che il vero M potrebbe arrivare a tutti nel giro di tre o cinque anni”, ha spiegato sempre alla MIT Tech Review Laurent Landowski, supervisore del progetto. “Ma potrebbero volerci dieci anni o forse anche di più”.